A Engenharia de Prompt tem emergido como um campo crucial no desenvolvimento de sistemas baseados em modelos de linguagem de grande porte (LLMs). Ela diz respeito à arte e ciência de projetar entradas (prompts) que orientem de forma eficaz o modelo a produzir as saídas desejadas. Uma técnica notável nesse contexto é a Cadeia de Pensamento (Chain of Thought, CoT), na qual o modelo é induzido a gerar etapas intermediárias de raciocínio antes de chegar à resposta final. Em vez de responder diretamente, o LLM “pensa em voz alta”, decompondo o problema em passos lógicos.

Estudos mostraram que esse método melhora significativamente o desempenho em tarefas complexas, como problemas matemáticos e de raciocínio lógico, pois auxilia o modelo a lidar com situações em que a relação entre a pergunta e a resposta não é trivial

. Wei et al. [1], por exemplo, demonstraram que prompts que estimulam a cadeia de pensamento permitem que modelos como o GPT-3 resolvam questões de aritmética e raciocínio que antes estavam fora de alcance, simplesmente por incluir instruções do tipo “Vamos pensar passo a passo”. Essa descoberta ressalta o poder de um prompt bem estruturado em revelar capacidades latentes do modelo que não se manifestam com uma pergunta direta.

PACER v1.1: Planejamento, Análise, Contemplação, Execução e Revisão

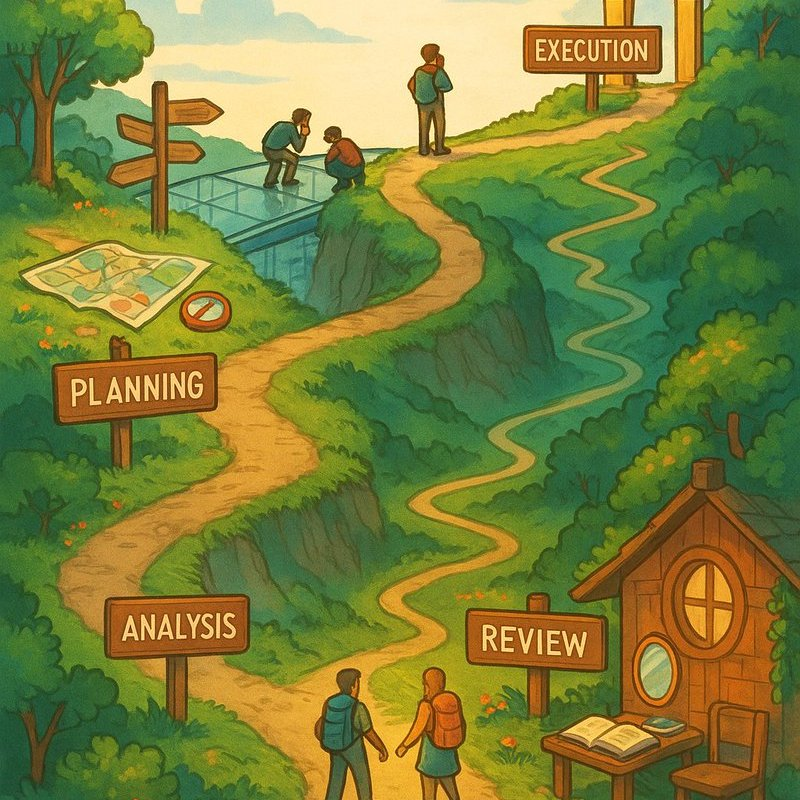

Diante dos avanços em Engenharia de Prompt, o método PACER v1.1 surge como uma evolução metodológica que integra diversas etapas inspiradas nessas técnicas de raciocínio orientado. PACER é um acrônimo para Planning, Analysis, Contemplation, Execution, Review, que em português correspondem a Planejamento, Análise, Contemplação, Execução e Revisão. Cada uma dessas fases estrutura o processo de solução de um problema de forma sequencial e deliberada, visando maximizar a eficácia e a clareza do raciocínio do modelo antes da resposta final.

Em termos práticos, o PACER v1.1 opera nas seguintes etapas:

- Planejamento: O modelo traça um plano de ação inicial. Nesta fase, delimita-se o escopo do problema e esboça-se uma estratégia de resolução. Por exemplo, para uma pergunta complexa, o LLM pode listar quais subproblemas precisam ser resolvidos ou quais informações devem ser lembradas. Essa etapa relaciona-se à ideia de “planejar antes de executar”, garantindo que o modelo tenha um roteiro a seguir antes de partir para a execução.

- Análise: Em seguida, o modelo analisa detalhadamente o problema e as informações disponíveis. É o momento de interpretar dados da entrada, reconhecer restrições e esclarecer objetivos. A análise aprofunda o entendimento, assegurando que nenhuma parte importante do enunciado seja negligenciada. Isso se alinha a práticas de decomposição do problema vistas em técnicas como o Least-to-Most Prompting, onde problemas complexos são divididos em partes mais simples a serem resolvidas sequencialmente [4].

- Contemplação: Na fase de contemplação, o modelo realiza o raciocínio deliberativo sobre a solução. Aqui ocorre efetivamente a cadeia de pensamento: o LLM avalia diferentes abordagens, considera hipóteses e potencialmente cria diversos “pensamentos” intermediários. Essa fase pode envolver a geração de múltiplos cenários ou caminhos de solução mentalmente, lembrando a estratégia de Tree of Thoughts proposta por Yao et al. [2], na qual o modelo explora uma árvore de possibilidades antes de decidir o próximo passo. A Contemplação incentiva um raciocínio aprofundado e multi-caminhos, em contraste com uma abordagem linear simples.

- Execução: Após planejar, analisar e contemplar, o modelo parte para a execução da tarefa. Esta é a geração da resposta ou solução em si, seguindo o plano traçado e o raciocínio desenvolvido nas etapas anteriores. Graças à preparação cuidadosa, a execução tende a ser mais acurada. Vale destacar que estudos de Cadeia de Pensamento indicam que, quando o modelo chega a este ponto com um raciocínio bem estruturado, a resposta final tem maior chance de estar correta [1].

- Revisão: Por fim, o modelo revisa e avalia a solução obtida. Nesta fase, o resultado é checado quanto à coerência e correção, e o modelo pode identificar possíveis erros ou lapsos em sua resposta. Caso sejam detectados problemas, o LLM pode refinar sua resposta, retornando às etapas anteriores se necessário. Essa fase de Revisão se inspira em técnicas de self-reflection prompting, nas quais o próprio modelo atua como crítico de sua saída, melhorando-a iterativamente [3]. Madaan et al. [3] demonstraram que permitir que o modelo forneça feedback sobre sua própria resposta e a refine em sucessivas iterações pode elevar significativamente a qualidade final, sem necessidade de intervenção humana direta.

Em conjunto, essas cinco fases do PACER v1.1 promovem um ciclo completo de raciocínio estruturado: da concepção do plano até a verificação do resultado.

yaml

pacer_v1_1:

lang: "pt-BR"

max_tokens: 2048

regras_gerais:

- "Percorra fases 1-5; fases 1-3 podem ser ocultas na saída."

- "Mantenha placeholders/variáveis intactos."

- "Evite mudanças estruturais salvo para clareza."

- "Mostre passos de raciocínio antes das conclusões."

- "Se solicitado JSON estruturado, produza EXACT_SCHEMA."

fases:

fase1_planning:

resumo_objetivo: "≤2 linhas."

etapas: "Até 7 numeradas."

prereqs: "Listar dependências por etapa."

preencher_se_json: ["task_description", "context", "subtasks"]

fase2_analysis:

etapa_critica: "Selecionar e ramificar (A,B,C)."

ramos: "Listar prós, contras, requisitos."

escolha: "Justificar ramo vencedor."

fase3_contemplation:

suposicoes: "Enumerar + validação."

inconsistencias: "Voltar à fase2 no máx 1x."

preserva_placeholders: true

fase4_execution:

prompt_target: "Se gerar prompt, emitir EXACT_SCHEMA; senão, responder mantendo raciocínio."

fase5_review:

sintese: "≤3 linhas."

proximos_passos: "Opcional."

autoavaliacao: "Se JSON, incluir nota rápida."

exact_schema: |

{

"task_description": "...",

"context": { "difficulty_level": "...", "target_audience": "...", "goal": "..." },

"subtasks": ["..."],

"output_format": { "type": "...", "specific_format": "..." },

"examples": [{ "input": "...", "output": "..." }],

"feedback": { "score": { "clarity": ".../10", "alignment": ".../10", "completeness": ".../10" }, "comments": "..." },

"notes": ["..."]

}

Fundamentos Teóricos e Comparativos

A estrutura multi-fase do PACER v1.1 apoia-se em fundamentações teóricas sólidas e em lições aprendidas de pesquisas recentes. Do ponto de vista cognitivo, dividir o processo de resolução em etapas reflete como humanos experientes abordam problemas complexos: primeiro planejam, depois analisam os detalhes, contemplam soluções possíveis, executam a solução escolhida e, por fim, revisam o resultado. Essa abordagem ecoa métodos clássicos de resolução de problemas em educação matemática (como os passos de Polya) e encontra respaldo nas novas técnicas de prompting.

Na literatura de LLMs, diversos trabalhos apontam benefícios de se estruturar o raciocínio em etapas. A Cadeia de Pensamento (CoT) de Wei et al. [1] já indicava que forçar um desdobramento passo a passo do raciocínio aumenta a capacidade do modelo de chegar a respostas corretas, especialmente em domínios como aritmética e perguntas de múltipla etapa. Isso ocorre porque o modelo passa a explorar o espaço de solução em vez de tentar recuperar a resposta de imediato. Expandindo essa ideia, Self-Consistency (Wang et al., 2022) propõe gerar múltiplas cadeias de pensamento para a mesma pergunta e então selecionar a resposta mais consensual entre elas, mostrando ganhos de robustez e acurácia [5]. Tal técnica reforça a noção de que diferentes trajetórias de raciocínio podem ser exploradas e comparadas – um princípio análogo à fase de Contemplação do PACER, onde múltiplos caminhos são mentalmente avaliados.

Outra contribuição teórica relevante é o conceito de Árvore de Pensamentos (Tree of Thoughts, ToT). Yao et al. [2] argumentam que, em vez de seguir uma única sequência linear de pensamento, um modelo pode se beneficiar de uma busca em árvore, ramificando suas ideias e avaliando várias possibilidades em paralelo. Em problemas que exigem planejamento estratégico ou exploração (como quebra-cabeças ou jogos), a abordagem de árvore mostrou-se extremamente eficaz. Por exemplo, em um desafio do tipo Game of 24, a técnica ToT elevou a taxa de sucesso do GPT-4 de apenas 4% (com CoT linear) para 74% de acerto

, um salto notável atribuído à capacidade do modelo de retroceder e tentar caminhos alternativos quando uma linha de raciocínio se mostra infrutífera. Esse resultado ilustra, na prática, a vantagem de estruturar o raciocínio de forma não linear. O PACER v1.1 incorpora esse insight ao prever, na fase de Contemplação, uma reflexão abrangente que pode considerar múltiplas abordagens antes de se comprometer com a execução.

Por fim, a etapa de Revisão no PACER é respaldada por técnicas de reflexão autônoma. Estratégias de self-reflection e refinamento automático têm ganhado destaque ao enfrentar limitações dos LLMs. Quando um modelo é incentivado a revisar criticamente sua resposta, pode identificar contradições ou erros factuais e corrigi-los. Trabalhos recentes demonstram esse potencial: Madaan et al. [3] introduziram um modelo de auto-refinamento que, sem dados adicionais de treinamento, refaz suas respostas com base em feedback gerado por ele próprio, alcançando melhorias de ~20% em tarefas que vão desde geração de diálogos até resolução de problemas matemáticos complexos. Essa capacidade de “pensar sobre a própria resposta” confere uma camada extra de segurança e qualidade ao resultado, e é exatamente o que PACER formaliza em sua última fase.

PACER v1.1 e a Melhoria Contínua de Prompts

Uma motivação prática para o desenvolvimento do PACER v1.1 é atender à necessidade de prompts mais eficazes e educativos, através de um processo de melhoria contínua. Em ambientes de aprendizado ou ao lidar com usuários, é desejável que o sistema não apenas acerte, mas também explique seu raciocínio de forma clara e se ajuste caso ocorra um equívoco. A arquitetura multi-fase do PACER facilita esse requisito de várias maneiras.

Primeiro, ao explicitar as etapas de raciocínio, PACER torna o prompt intrinsecamente didático. Cada fase pode ser vista como um passo pedagógico: Planejamento equivale a ensinar a importância de traçar um plano; Análise corresponde a compreender bem o problema antes de responder; Contemplação mostra o valor de considerar alternativas; Execução demonstra a síntese final; e Revisão evidencia a utilidade de conferir o trabalho realizado. Assim, quando utilizado em contexto educacional (por exemplo, um tutor de matemática automatizado), o modelo não apenas dá a resposta, mas guia o estudante pelo processo de solução, satisfazendo objetivos educacionais de transparência e compreensão.

Segundo, o PACER v1.1 permite a retroalimentação contínua do prompt. Graças à fase de Revisão, o próprio sistema pode avaliar se o prompt inicial foi suficiente ou adequado para produzir a resposta correta. Se identificar falhas, pode-se reformular internamente a abordagem – essencialmente, melhorando o prompt para uma próxima iteração. Essa ideia conecta-se a práticas de melhoria iterativa de prompts descritas na literatura [3][5].

Por exemplo, a técnica de Least-to-Most [4] pode ser vista como uma forma de melhorar gradualmente as instruções: comece com um prompt que resolve um caso mais simples e vá aumentando a complexidade. De modo semelhante, o PACER pode ser ajustado dinamicamente; se o modelo falha na fase de Execução, a fase de Revisão pode gerar um novo plano ou nova análise, refinando o processo. Em suma, o design multi-fase atua como um loop de aprimoramento, onde cada etapa informa a seguinte e eventuais erros retroagem para correção. Isso eleva a resiliência do sistema a falhas de entendimento ou formulação do prompt inicial.

Notavelmente, essa integração de avaliação e refinamento automáticos alinha-se com esforços para tornar LLMs mais autônomos em sua melhoria. Técnicas como Self-Refine [3] e Self-Correction equipam o modelo com habilidades metacognitivas – isto é, ele pode pensar sobre sua própria resposta e sobre a qualidade de sua instrução. PACER v1.1 encapsula esses princípios dentro de um único arcabouço coerente, servindo como um guia tanto para o engenheiro de prompt (humano) quanto para o próprio modelo durante a geração.

Benefícios: Robustez, Transparência e Flexibilidade

A adoção do PACER v1.1 na Engenharia de Prompt traz diversos benefícios notáveis:

- Robustez: Ao segmentar o processo em múltiplas fases com verificações internas (como a Revisão), reduz-se a chance de erros passarem despercebidos. Mesmo que o modelo cometa um deslize em uma etapa, há oportunidade de correção adiante. Além disso, a fase de Contemplação, potencialmente explorando várias abordagens, confere robustez diante de incertezas – semelhante à votação por múltiplas cadeias de pensamento do self-consistency [5]. Essa redundância inteligente significa que a resposta final tende a ser mais confiável, pois foi testada mentalmente sob diferentes ângulos.

- Transparência: Uma sequência estruturada de pensamento torna o funcionamento do modelo mais transparente e interpretável. Em vez de uma “caixa-preta” que salta da pergunta à resposta, o PACER expõe o raciocínio intermediário. Isso é valioso tanto para desenvolvedores quanto para usuários finais: permite auditar como o modelo chegou a certa conclusão e identificar onde uma eventual falha de lógica ocorreu. Em aplicações sensíveis, essa transparência aumenta a confiabilidade e facilita o aprimoramento colaborativo, pois humanos podem intervir em uma fase específica se necessário.

- Flexibilidade: O framework em fases do PACER é flexível e adaptável a diversos tipos de tarefas. Pode-se estender ou personalizar cada fase conforme o domínio – por exemplo, inserindo uma sub-fase de Consulta a uma base de conhecimento entre a Análise e a Contemplação, caso o problema exija buscar informações externas. Da mesma forma, se uma tarefa for trivial, certas fases podem ser condensadas. Essa modularidade significa que PACER não é uma receita rígida, mas sim um esquema adaptativo. Ele acomoda técnicas já existentes (CoT, ToT, auto-reflexão) como casos particulares ou complementos dentro de suas etapas. Assim, desde resolver um cálculo matemático passo a passo até escrever código a partir de uma descrição textual, o método PACER pode ser ajustado para guiar o LLM de maneira eficiente.

O PACER v1.1 representa uma síntese poderosa de práticas de Engenharia de Prompt orientadas ao raciocínio estruturado. Ao articular Planejamento, Análise, Contemplação, Execução e Revisão em uma sequência lógica, fornece um roteiro claro tanto para o modelo de linguagem quanto para o desenvolvedor humano. Essa organização prévia do raciocínio antes da geração da resposta demonstra-se fundamental para aproveitar ao máximo as capacidades dos LLMs, conforme evidenciado por abordagens como Cadeia de Pensamento [1] e Árvore de Pensamentos [2]. Em essência, o PACER v1.1 enfatiza que como perguntamos importa: estruturar o pensamento do sistema antes da execução não apenas melhora a acurácia das respostas, mas também sua explicabilidade e confiabilidade.

Em um cenário onde modelos de linguagem são cada vez mais responsáveis por tarefas complexas e críticas, metodologias como o PACER v1.1 destacam-se por trazer robustez, ao mitigar falhas através de revisão; transparência, ao revelar o processo de pensar do modelo; e flexibilidade, ao incorporar múltiplas estratégias de resolução de problemas. Ao resumir a importância de estruturar o raciocínio previamente, concluímos que frameworks multi-fase como o PACER v1.1 podem ser a chave para expandir os limites do que os modelos de IA conseguem alcançar de forma segura e eficaz.

Referências

[1] J. Wei, X. Wang, D. Schuurmans, M. Bosma, E. Chi, Q. V. Le, & D. Zhou (2022). Chain-of-Thought Prompting Elicits Reasoning in Large Language Models. arXiv:2201.11903.

[2] S. Yao, D. Yu, J. Zhao, I. Shafran, T. L. Griffiths, Y. Cao, & K. Narasimhan (2023). Tree of Thoughts: Deliberate Problem Solving with Large Language Models. arXiv:2305.10601.

[3] A. Madaan, N. Tandon, P. Gupta, S. Hallinan, L. Gao, et al. (2023). Self-Refine: Iterative Refinement with Self-Feedback. arXiv:2303.17651.

[4] D. Zhou, N. Schärli, L. Hou, J. Wei, N. Scales, et al. (2022). Least-to-Most Prompting Enables Complex Reasoning in Large Language Models. arXiv:2205.10625.

[5] X. Wang, J. Wei, D. Schuurmans, Q. Le, E. Chi, & D. Zhou (2022). Self-Consistency Improves Chain-of-Thought Reasoning in Language Models. arXiv:2203.11171.